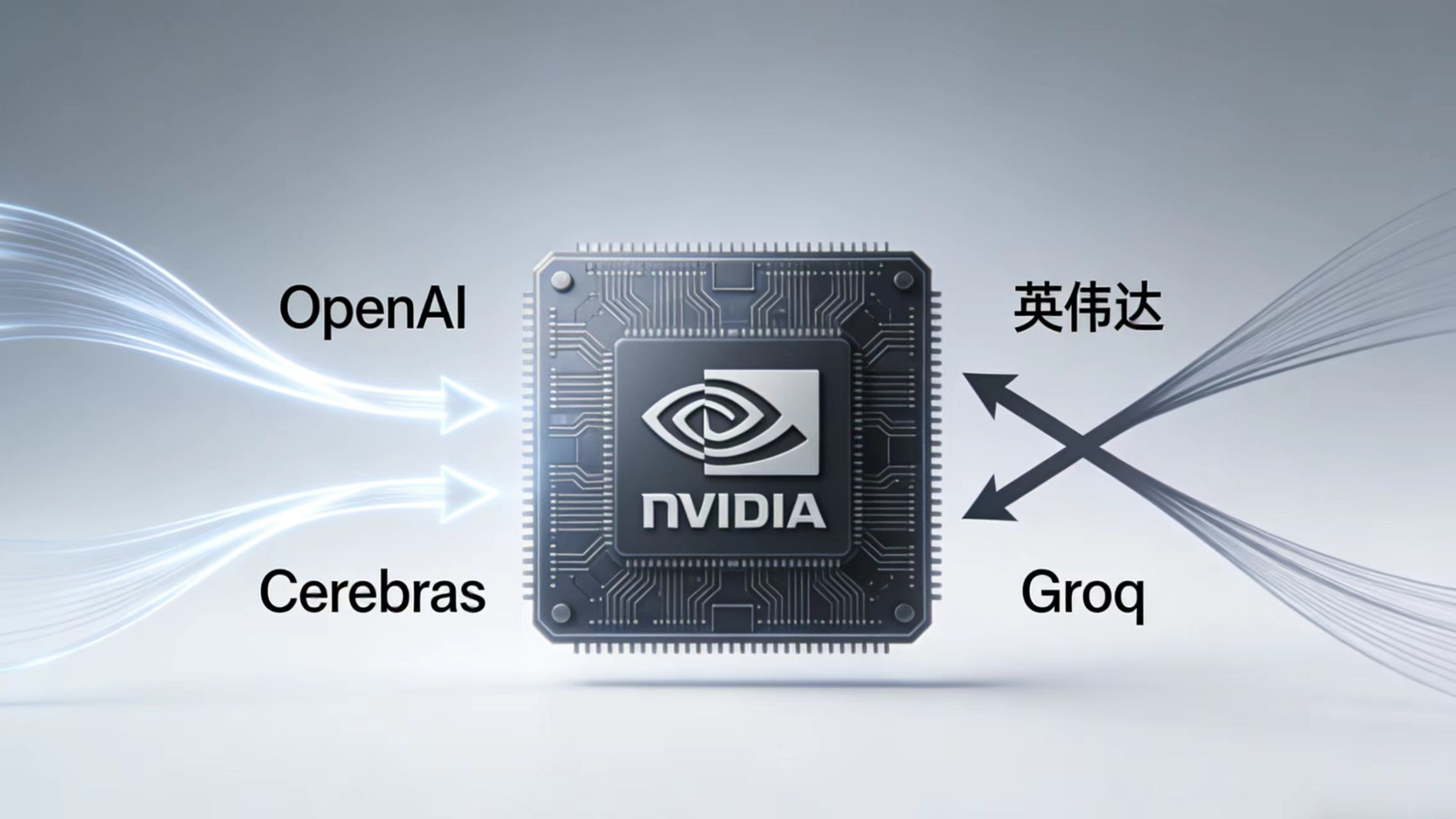

OpenAI”叛逃”英伟达:一场关于速度的芯片战争

当奥特曼不再等待黄仁勋

OpenAI正在系统性寻找英伟达之外的算力替代方案。这并非一时冲动,而是源于对英伟达最新一代AI芯片在推理环节——尤其是响应速度——表现的失望。据知情人士透露,双方原本正在洽谈一项涉及1000亿美元的投资与供货协议,但该谈判已拖延数月。

这场”分手”的导火索很具体:代码生成和复杂软件交互场景中,现有硬件的响应速度已成为用户体验的瓶颈。山姆·奥特曼曾公开指出,开发者等专业用户对代码类模型的生成速度极度敏感。当ChatGPT需要让用户”等一下”时,等待本身就成了产品体验的敌人。

推理时代来了,训练时代正在退场

AI行业正在经历一场静默但深刻的转向。过去几年,所有头条都在谈论谁训练出了最大的模型;现在,战场转移到了”谁能最快地回答用户的问题”。

据德勤预测,到2026年推理工作负载将占所有AI计算的三分之二,而2023年这一比例仅为三分之一。联想CEO杨元庆在CES 2026上直言:“过去80%的支出来自训练,20%来自推理;未来这两个数字将颠倒。”

OpenAI的战略重心也随之偏移。公司计算基础设施负责人Sachin Katti表示,OpenAI正在构建一个”弹性系统组合”,将合适的系统匹配到合适的工作负载上。翻译成人话:不再把所有鸡蛋放在英伟达这一个篮子里。

Cerebras:那个做”盘子大芯片”的家伙

OpenAI的”新欢”是Cerebras——一家以制造餐盘大小的晶圆级芯片而闻名的公司。1月14日,双方宣布了一项价值超过100亿美元的多年合作协议,Cerebras将在2026年至2028年间为OpenAI提供高达750兆瓦的计算能力。

Cerebras的核心卖点是速度。其晶圆级引擎架构将海量计算、内存和带宽集成在单一芯片上,消除了传统GPU集群中芯片间数据传输的延迟瓶颈。据独立测试,Cerebras在处理Meta的Llama 4 Maverick模型时速度达到每秒2522个token,而英伟达旗舰Blackwell B200为每秒1038个token——差距超过2.4倍。对于需要长输出的推理任务,优势可扩大到21倍。

Cerebras CEO Andrew Feldman的比喻很生动:“正如宽带改变了互联网,实时推理将改变人工智能。”

Groq:一场被截胡的约会

有趣的是,OpenAI此前还曾与另一家推理芯片公司Groq接触。Groq以其语言处理单元(LPU)著称,同样专注于低延迟推理加速。但这场潜在的”约会”被英伟达以一种独特的方式终结了。

2025年12月24日,英伟达宣布与Groq达成一项价值约200亿美元的非独家技术许可协议,同时”挖走”了Groq创始人Jonathan Ross、总裁Sunny Madra及大部分工程团队。这不是传统意义上的收购——Groq仍作为独立公司运营其云服务GroqCloud,但核心技术和人才已归英伟达所有。

这种”反向人才收购”的结构帮助英伟达规避了反垄断审查,同时消除了一个潜在的架构威胁。Jonathan Ross曾是谷歌TPU项目的负责人,他的加入意味着英伟达正在认真对待推理市场的竞争。

英伟达的护城河与裂缝

英伟达目前仍占据AI芯片市场约85%的份额。其CUDA软件生态系统拥有超过90%的AI开发者熟悉度,形成了强大的锁定效应。正如一位分析师所说:“即使想用其他芯片,也得重写代码。”

但护城河正在出现裂缝。AMD通过与OpenAI签署60亿美元的计算能力采购协议(附带1.6亿股AMD股票认购权),正在获得实质性 foothold。微软推出了自研AI芯片Maia 200,谷歌的TPU Ironwood已进入第七代,亚马逊的Trainium也在迭代。

更关键的是,推理市场的特性与训练不同。训练需要极致的并行计算能力,是英伟达GPU的强项;而推理更强调低延迟、能效比和成本效益,这为专门优化的架构打开了窗口。

奥特曼的算盘

山姆·奥特曼本人是Cerebras的早期投资者,两家公司自2017年起就保持着定期交流。2025年,双方还合作优化了OpenAI的开源模型GPT-OSS在Cerebras芯片上的运行表现。

这笔交易的深层逻辑不难理解:一方面,多元化供应链降低了对单一供应商的依赖和议价劣势;另一方面,Cerebras的速度优势可以直接转化为ChatGPT等产品的用户体验提升。对于拥有超过9亿周活跃用户的OpenAI来说,每毫秒的延迟减少都意味着巨大的 engagement 回报。

此外,与Cerebras的合作采用”租用计算时间”模式而非直接购买硬件,这与云基础设施模型类似,提供了更大的灵活性。

黄仁勋的反击

面对挑战,英伟达并非坐以待毙。除了通过Groq交易补强推理技术,公司还在推进下一代Vera Rubin架构,计划将Groq的SRAM优先设计理念融入其中。

英伟达CEO黄仁勋在内部邮件中表示,计划将Groq的低延迟处理器集成到英伟达的”AI工厂”架构中,扩展平台以服务于更广泛的AI推理和实时工作负载。

在公开场合,黄仁勋极力否认与OpenAI关系紧张的传闻。但市场正在用实际行动投票:当OpenAI开始真金白银地为第三方推理芯片下单,AI算力市场的”一超多强”格局正面临重塑。

谁将赢得这场战争?

这个问题或许问错了。更准确的问法是:这场战争将如何改变AI行业的权力结构?

对于终端用户来说,竞争意味着更快、更便宜的AI服务。对于芯片行业来说,通用GPU与专用推理架构的共存可能成为新常态。对于OpenAI这样的模型公司来说,掌握算力选择的主动权意味着更大的战略自由度。

正如Cerebras在其博客中所写:“OpenAI和Cerebras都成立于2015年,怀揣着对未来的激进愿景。OpenAI致力于创造驱动AGI的软件,Cerebras则颠覆了关于芯片制造的传统认知。我们相信,模型规模和硬件架构终将汇合的时刻已经到来。”

那个时刻,就是现在。

(参考来源:AI Base、Tech in Asia、Byte Iota、Cerebras官方博客、Groq官方声明、Next Platform、Intelacia)

编辑:Laverne