腾讯混元发布CL-bench评估基准

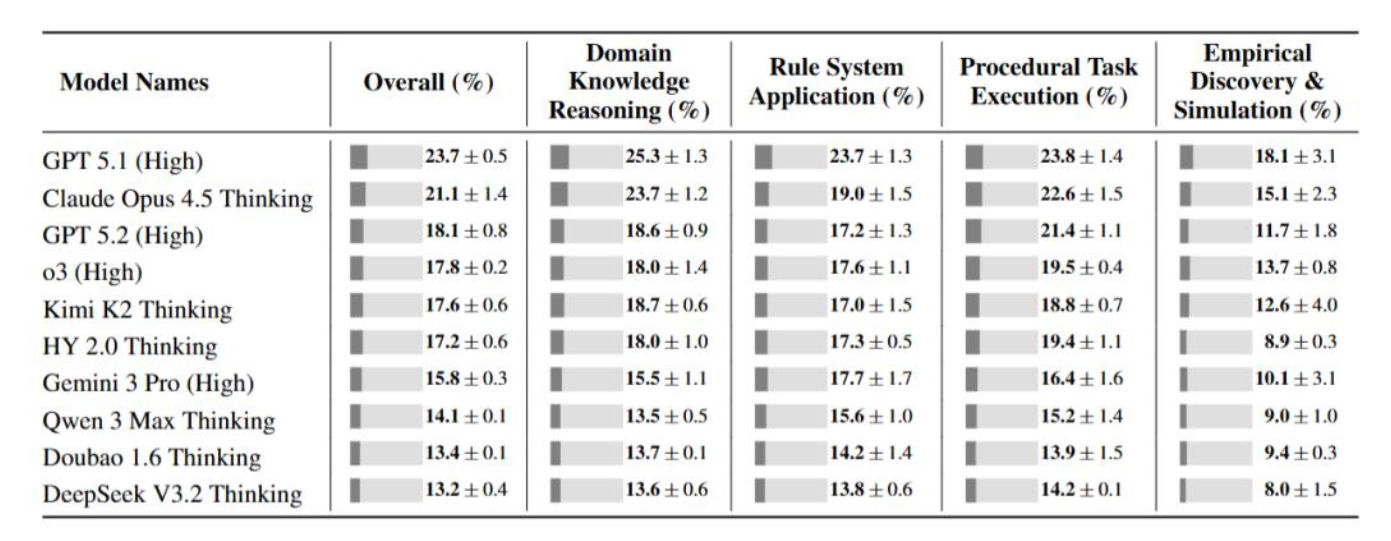

这是姚顺雨加入腾讯后首篇署名 论文。该基准专测模型能否从上下文学习新知识并正确应用。结果显示模型平均仅解决17.2%任务,最好的GPT-5.1也才23.7%。这揭示了一个真相:模型还不会真正利用上下文。

姚顺雨入职腾讯第50天,甩出一份让AI行业集体脸红的成绩单。他领衔发布的CL-bench基准测试显示,所有前沿大模型平均仅能完成17.2%的任务,即便最强的GPT-5.1(High)也只有23.7%——这相当于满分100分的考试,全班最高分不到24分。

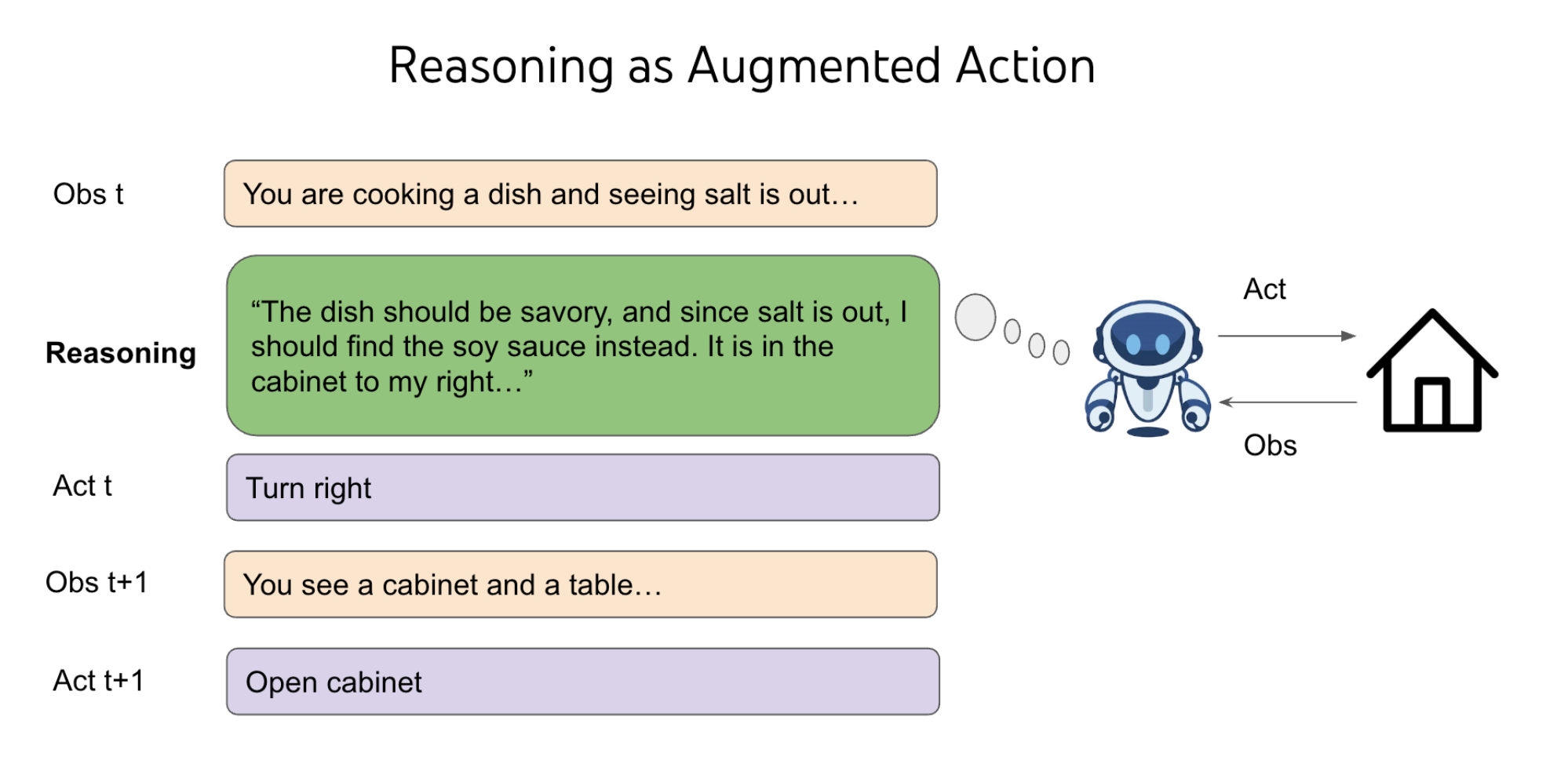

这份"低分卷"正是姚顺雨去年预言的兑现。2025年4月,他在OpenAI任职期间写下《下半场》,声称AI重心必须从"解决问题"转向"定义问题";如今这份500个复杂上下文、1899个任务的评测集,精准标记出模型的致命盲区:它们能像富内斯般记住一切,却无法像人类一样从现场学习。

来源:ysymyth.github.io

测试设计堪称刁钻。所有知识均来自模型预训练之外的虚构领域——小众法律体系、创新金融工具、实验数据归纳——迫使AI必须"现学现卖"。结果暴露残酷真相:模型要么无视上下文中的新规则,要么将旧知识生搬硬套;在需要归纳规律的"经验发现"类任务中,成功率甚至跌破10%。

腾讯混元技术团队将此归因于"静态参数记忆"的诅咒。当前模型优化方向是让预训练知识更牢固,而非让实时学习更灵活;这与真实世界的工作逻辑完全相悖——人类工程师面对新需求时,首要能力是读文档、学新规,而非背诵旧代码。

CL-bench的发布时机耐人寻味。就在DeepSeek以低成本训练震撼行业、OpenAI与谷歌卷多模态Agent之际,姚顺雨将焦点拉回基础能力:若AI连上下文都学不会,谈何通用智能?这份"差评"或许比任何刷榜都更具价值——毕竟,能精准诊断无知,才是真正的博学。